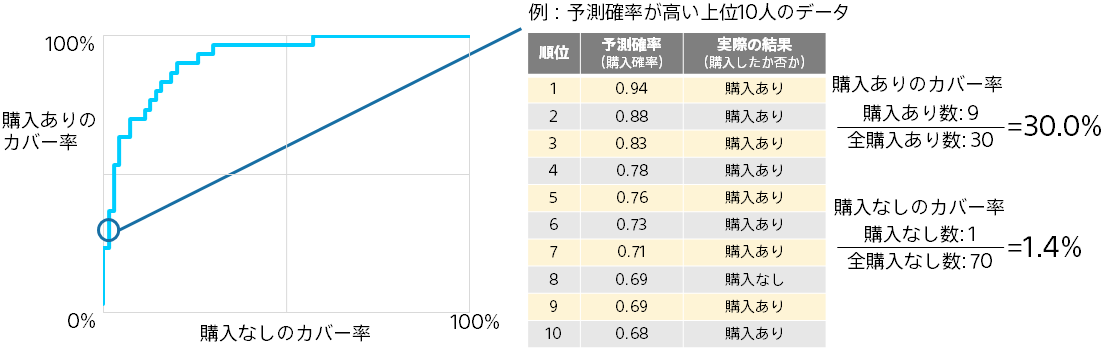

ROC カーブは、「予測確率上位の正解率」と同様に、予測確率上位のデータにおける購入ありと購入なしの個数に基づグラフです。

上位1位から順に各順位までのデータで、購入ありのカバー率と購入なしのカバー率を算出しプロットしていくことでグラフを作成します。

左上に膨らむほど(上位で購入ありが多いほど)予測精度が高いことになります。グラフの直観的な理解は難しいので必ずしも理解する必要はありません。

ROC カーブの下の面積を AUC(Area Under the ROC Curve)と言います。0 以上 1 以下の値で、大きいほど良い予測精度であることを表します。

Accuracy, Recall, Precision, F 値と違って、予測確率と実際の結果のみで決まる値なので(予測結果を決めるための閾値に左右されないので)、二値分類の予測精度の評価値としてよく利用されます。